Ihr kennt es wahrscheinlich alle: Für die letzten Sim Updates des Microsoft Flight Simulator lief der Download alles andere als rund. Da freut man sich auf neue Inhalte und Verbesserungen für den MSFS, und anstatt diese schnell auf die Platte zu laden, sitzt man da und schaut stundenlang auf den immergleichen Bildschirm mit dem Gefühl, dass die Bytes einzeln durch die Leitung kriechen.

Da diese Probleme nun beim diese Woche erschienen Sim Update 14 wieder aufgetreten sind, obwohl diese nach dem ebenfalls holprigen Release des Sim Update 13 im September behoben sein sollten, gibt es nun vom MSFS-Team eine Fehleranalyse, warum die Probleme aufgetreten sind und wieso die Fehlerbehebung im September nicht funktioniert hat. Und damit ihr nicht nur Flughafen versteht, fassen wir diesen Geschichte für euch nochmal zusammen.

Die Azure-Wolke

Um die Problematik zu verstehen braucht es erst ein wenig Hintergrundwissen darüber, wie die Infrastruktur des MSFS aufgebaut ist und welche die Daten für die Sim Updates verteilt. Diese werden nicht direkt vom Quellserver geladen, sondern über ein sogenanntes Content Delivery Network (CDN) verteilt. Der Zwecke eines solches CDN ist es durch mehrere verfügbare Server die für den Kunden insgesamt verfügbare Quellbandbreite erhöht. Dies und die Tatsache, dass die CDN Server global verteilt stehen und damit theoretisch geringere Latenzen haben, als zum Beispiel die ganze Welt direkt aus den USA laden zu lassen, soll einen schnellen Download für alle Simmer ermöglichen. So weit die Theorie.

Nun muss dieses CDN aber selbst auch erst einmal mit Daten versorgt werden. Hier kommt ein Team innerhalb von Microsoft zum Tragen, welches sich PlayFab nennt. Diese befinden sich, wie wahrscheinlich auch der größte Teil der CDN Server, in der Microsoft Azure Umgebung und halten die Daten vor, welche an das CDN und von dort an die Simmer verteilt werden. Damit sich gewiefte Simmer jetzt aber nicht direkt an die PlayFab wenden und dort die Daten laden, wenn es Ihnen via CDN zu langsam geht, braucht es noch eine Sicherheitsfunktion zwischen der PlayFab und dem CDN.

Dafür kommen sogenannte SAS-Token zum Einsatz. Diese werden von der PlayFab an legitime CDN-Server verteilt und erlauben diesen den Download von Daten aus der PlayFab. Die Token haben aber noch eine zweite Funktion: Sie werden erneuert, wenn sich die im PlayFab liegenden Daten ändern. So weiß das CDN, dass es sich neue Daten laden muss, wenn es einen neuen Token erhält.

Im normalen Betrieb des MSFS halten die Token dabei 48 Stunden, sodass jeder Server des CDN alle zwei Tage einmal die Daten abgleicht. Dies ist auch gewollt, da es durchaus mal passieren kann, dass es ein Server kein Token bekommt, wenn sich Dinge ändern, da es bei der Auslieferung zum Server verloren geht. So ist sichergestellt, dass nicht allzu lange falsche Daten auf den CDN-Servern liegen.

Sim Update 13

Soweit zu dem normalen Prozess, welcher Installationen und Updates ausliefert. Dieser Prozess wird natürlich bei jedem neuen Update auf die Probe gestellt, da hier jedes Mal die mit Abstand größten Lasten für das System auftreten, wenn alle Simmer ihren MSFS natürlich updaten müssen und wollen.

Dies wurde dann beim Release des Sim Update 13 zum Verhängnis, da hier massive Probleme beim Download auftraten. Ungewöhnlich war bei diesem Sim Update, dass der Zeitraum vor dem Release einer der längsten in der Geschichte des MSFS war, in dem keine größeren Updates ausgeliefert wurden. (Anmerkung: World und City Updates und neuer Content Marktplatz werden anders ausgeliefert und sind daher hier nicht relevant).

Da aber auch der Rest der Welt nicht stillsteht, wurde in dieser Zeit an der PlayFab gearbeitet und diese auch gewartet, wobei sich ein Fehler eingeschlichen hat, welcher dann unter der Last des SU13 die ganze Struktur zum Einsturz brachte.

Zwar fing der Release des Sim Update ganz normal an, ohne dass es Auffälligkeiten im System gab. Aber als immer mehr Simmer anfingen sich die Daten zu laden, kam das CDN deutlich schneller als erwartet an sein Grenzen und konnte nicht mehr die benötigte Datenmenge ausliefern. Dies hatte zur Folge, dass bei uns nur noch wenig oder gar keine Daten mehr ankamen. Damit war ein Troubleshooting notwendig, welches innerhalb von einer Stunde nach dem Release des SU13 anlief. Dies konnte das Problem schlussendlich auf die PlayFab eingrenzen, da sich hier in der Zeit seit dem letzten Update des MSFS in einer Wartung ein Fehler eingeschlichen hatte. Dieses stellte die SAS Token, die wir oben kennengelernt haben, extrem häufig neu aus, teilweise wohl bis zu mehrere Male pro Sekunde. Die Server des CDN können zwar auch so weiterhin Daten ausliefern, da bis zu einem Update der Daten bei ihnen immer der letzte Stand ausgeliefert wird, den sie haben, aber das CDN hat deutlich weniger Kapazität, da die Server permanent schauen müssen, ob und welche Daten sich in der PlayFab geändert haben.

Als schneller Fix wurde während des Release des SU13 das PlayFab so gefixed, dass dieses nur noch alle 15 Minuten einen neuen SAS Token erzeugt. Damit hatten die Server des CDN dann wieder genug Kapazität, das Update an alle Simmer zu verteilen.

Also war alles wieder gut und keine Probleme mehr zu erwarten? Nunja, wie wir mittlerweile wissen, nicht ganz. Ihr könnt vielleicht in der Beschreibung des Fix oben sehen, wo hier für die Zukunft das Problem liegen könnte. Wenn ja, schreibt es gerne unten in die Kommentare!

Sim Update 14

So. Kommen wir zum vergangenen Dienstag. Wieder startete das Sim Update wie gewohnt und die ersten Minuten nach Release lief erstmal alles normal, Downloads wurden mehr und mehr, aber es liefen erstmal keine großen Fehler im Monitoring auf.

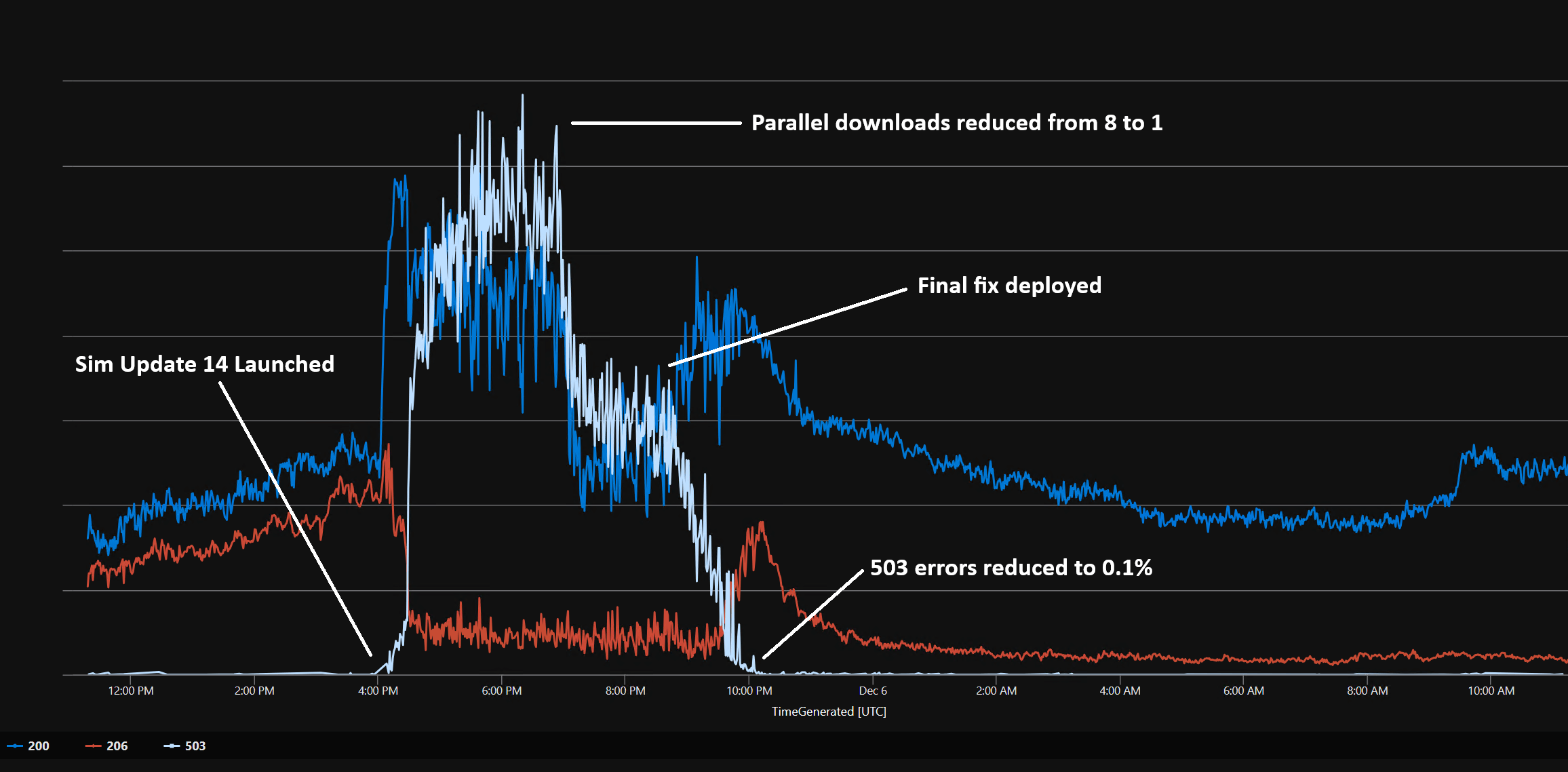

Doch dann, bis circa eine Viertelstunde nach dem Release des Updates die erfolgreichen Downloads nicht mehr steigen und dafür die Anzahl an fehlgeschlagenen Download schnell mehr wird. Und auch hier startete nun schnell wieder das Troubleshooting und die Ursachensuche ging los. Dazu hat Microsoft in ihrem Posting auch einen Graphen erstellt, welcher den Verlauf des Problems zeigt.

Interessant für uns sind dabei nur die beiden blauen Linien, die rote Linie ist nur technisch im Detail interessant. Dabei ist die dunkelblaue Linie die Zahl der erfolgreichen Download-Anfragen an das CDN, die hellblaue Linie sind die durch das CDN abgelehnten Download-Anfragen.

Bevor wir hier in das Detail der Probleme gehen ist es noch wichtig, ein Detail des Sim Update 14 im Hinterkopf zu behalten: Denn dies enthielt im Vergleich zum SU 13 mehrere sehr große Dateien wie die neue Cirrus SR22 oder die ominöse Soundbank, welche bei vielen Screenshots von fehlgeschlagenen Updates in Foren und sozialen Medien zu sehen war.

Nun zu dem Graphen oben. Wir können hier sehen, dass für das Troubleshooting es zwei Versuche brauchte, bis das Problem gelöst werden konnte. Im ersten Versuch hat das Team die Zahl der möglichen parallelen Downloads für alle reduziert, was bei einer einfachen Überlastung des CDN zwar den Download für alle langsamer, aber zumindest erfolgreich gemacht hätte. Wie wir sehen, führte diese aber nicht zu einer Besserung, da die Anzahl der Downloads insgesamt sank, aber immer noch über die Hälfte der Download-Anfragen abgelehnt wurde. Die Anzahl wurde erst durch den zweiten Fix behoben, welcher später ausgerollt wurde.

Und auch hier war die Ursache am Ende wieder die Verbindung zwischen dem PlayFab und dem CDN. Zwar war mit dem 15-Minuten-Token-Update-Zyklus nach dem Sim Update 13 das eigentliche Problem behoben, dass die CDN Server permanent damit beschäftigt waren, die Daten abzugleichen, aber diese Server müssen für den Abgleich immer noch alle 15 Minuten die Daten neu laden aus der PlayFab, Tja, und dafür wird Bandbreite benötigt. Und diese Bandbreite ging, bedingt auch durch die großen Dateien im SU14, beim Release des Updates auf der PlayFab aus.

Die Korrektur folgte: Um dies zu beheben, wurde etwas später ein Fix eingespielt, welcher die ganz ursprüngliche Konfiguration des PlayFab wiederherstellte, mit einem Token Update alle 48 Stunden, wenn sich zwischendurch keine Dateien ändern. Und zum Schluss wurde das MSFS-Team durch dieses fehlerhafte Update noch auf eine weitere Fehlkonfiguration aufmerksam, welche zwar nicht ursächlich für den Ausfall war, aber in Zukunft bei ähnlichen Situationen etwas Besserung verspricht.

Denn bisher war der Sim so konfiguriert, dass er nach einer abgelehnten Download-Anfrage bis zu zehn Minuten gewartet hat, bis eine neue Anfrage gestartet wurde. Dies führte bei vielen abgelehnten Anfragen dazu, dass bei manchen Simmern für sehr lange Zeit einfach gar nichts passierte. Und daher für Frust sorgt. Diese Wartezeit wurde nun auf maximal eine Minute begrenzt.

Jetzt bleibt die Frage: Was passiert in der Zukunft? Den Sim Updates wird es immer wieder geben. Mit diesen Fixes sollte der MSFS wieder für zukünftige Sim Updates gerüstet sein und keine solchen extremen Ausfälle wie bei den letzten beiden Updates produzieren.

Doch einen kleinen Beigeschmackt gibt es: Diese Fixes bedeuten nicht, dass die Updates automatisch schneller herunterladen vor und nach Simstart. Das Downloadgeschwindigkeits-Thema ist weiterhin ungeklärt und es gibt keine wirklich vollständige Erklärung zu der Ursache. Nur eine Andeutung im letzten Entwicklerstream, dass hier wohl auch diverse Internetprovider mit hereinspielen und eventuell Dinge drosseln, die sie nicht drosseln sollten. Sobald es hier weitere Infos gibt, halten wir euch natürlich auf dem Laufenden.

Wenn ich’s halbwegs richtig verstanden habe ohne mich allzu sehr in die Materie zu vertiefen, stinkt hier der Fisch wohl bereits am Kopf, sprich bei Microsoft und seiner Infrastruktur.

Um diese wieder aufkehrenden Problem bei großen Updates zu beheben müßte man von Seiten M’s grundlegend die Content Delivery Network (CDN) Server-Struktur ausbauen-/erweitern.

Ein Großteil der CDN’s mag sich zwar in der Microsoft Azure Umgebung befinden, wahrscheinlich aber nicht alle, sodass es auch hier zu Engpässen und Flaschenhälsen kommt. Die Abgleichzeiten für die Token sollte man vielleicht von 48 Stunden auf 24h oder 36 Stunden reduzieren, sodass diese Server keine Zeit verschwenden mit Abgleich-Latenzen, und somit die Daten schneller frei geben, was evt. auch noch mal etwas zusätzlichen Speed im Verteilernetz bringen könnte.

Grundlegend wurde wahrscheinlich der große weltweite Erfolg des MSFS, zu seinem eigenen, größten Feind !

Man hat, um es platt zu sagen, einfach nicht damit gerechnet das dermaßen viele Kunden am Erlebnis MSFS teilhaben wollen. Jetzt rennen die Leute ihnen ständig die Bude ein und man hat für diesen Ansturm eigentlich noch nicht die erforderlichen Kapazitäten bzg. Infrastruktur; was man aktuell hat sind Workarounds und Flickenteppiche.

Um das aber dauerhaft zu beheben müßte Microsoft ordentlich Geld in die Hand nehmen, die CDN’s ausbauen, Azur grundlegend erweitern, etc.. – was wiederum die Gewinn/Verlust Bilanz des MSFS empfindlich stören könnte.

Und: warum diese Strukturen weltweit ausbauen, nur für einen ollen Flugsimulator wenn der Rest außerhalb unserer Simmerwelt für MS sowieso bestens läuft.

Man darf hier niemals vergessen: Microsoft macht den weitaus größten Teil seiner Gewinne über das Sammeln und Verkaufen von Daten. Irgendwelche Software-Anwendungen einschließlich des MSFS und Betribessysteme sind schon längst zum Nebengeschäft geworden.

„Man darf hier niemals vergessen: Microsoft macht den weitaus größten Teil seiner Gewinne über das Sammeln und Verkaufen von Daten. Irgendwelche Software-Anwendungen einschließlich des MSFS und Betribessysteme sind schon längst zum Nebengeschäft geworden.“

Das ist faktisch falsch.

Microsoft ist kein Datenheler wie Google.

Laut Geschäftsbericht 2023 ist die Haupteinnahmequelle das cloud Geschäft und an zweiter Stelle die Lizenz Einnahmen aus dem Geschäftskunden Geschäft für services ( Windows, office usw)

Und das es windows quasi eine zeitlang kostenlosel gab ist immer noch die alte Taktik „user hat windows zu hause, also will user auch windows km Büro“

Nein, du liegst definitiv falsch und lebst schon längst in der Vergangenheit die noch vor ca. 15 bis 40 Jahren ihre Gültigkeit hatte !

Mit Leuten wie dir (vor allem in Deutschland) ist es sehr mühsam, weil ihr informationstechnisch meist Jahre zurück liegt.

Die erforderliche „Mühsal“ der Recherche werde ich dir sicher nicht abnehmen; das Internet und entsprechende IT-Kanäle (sogar bekannte Youtuber und Techchannels, wie zB. JayzTwoCents u.v.a) sind mittlerweile voll mit Berichten und Belegen wie Microsoft mit unseren Daten im großen Stil seit Jahren Geschäfte macht, nur sind diese Kanäle meist Englisch sprachig, was nicht wundert.

Und nein, keine Verschwörungstheorien, einfach nur knallharte Fakten und Business.

Wie geschrieben, ich werde dir die Arbeit hinter den Vorhang zu gucken sicher nicht abnehmen, denn viele wollen das (besonders in Deutschland) ja gar nicht; lebe ruhig weiter in deiner Vergangenheit.

Trotzdem, als (kleine) Kostprobe ein Artikel zum Thema Microsoft und Datensammeln, dieser ist sogar auf Deutsch:

https://www.heise.de/news/Untersuchung-Microsoft-Office-sammelt-Daten-und-verstoesst-gegen-die-DSGVO-4224823.html

Mit Verlaub, aber dieser Rundunschlag („Mit Leuten wie dir […] ist es sehr mühsam […]“) ist doch echt unangebracht, vor allem wenn dann als einziger Beleg kommt, dass Microsoft die Übersetzungen von Word in der Cloud macht.

Ich bin da grundsätzlich eher bei Jens, das Cloud-Geschäft besteht ja vor allem daraus, Hosting-Provider mit Extras für Geschäftskunden zu sein, und da verkaufen die sich halt auch richtig gut. Der restliche Push in die Cloud sehe ich auch eher aus der Richtung, dass es einen hervorragend Vendor-Lock-In ermöglicht und sich dadurch leichter Subscriptions verkaufen lassen. Ich finde das auch nicht gut, aber es ist nun einmal die naheliegende Begründung.

Die Idee, dass man sich bei Microsoft einen abspritzt weil sie jetzt endlich den Geburtstagsbrief von der Oma lesen können, ist dann eben doch Verschwörungstheorie. In Deutschland ist man da eben so 15-40 Jahre hinterher, in der IT führende Nationen wie die USA sind schon lange all-in in der Cloud.

@Jens: Außerdem hast du geschrieben:

Wie dumm und (gewollt?) blind kann man an dieser Stelle nur sein 🤣 : gerade die Cloud speichert ungehemmt und auf Teufel komm raus unsere Daten.

Glaubst du, dass die Cloud eine Schäfchenwolke im Himmel ist ?

Wer, glaubst du, stellt letzten Endes die Cloud zur Verfügung und die gesamte, zugehörige Infrastruktur ?

Warum, glaubst du, will der Softwargigant Microsoft seit Jahren alles und jedes immer in die Cloud verlagern, selbst Cloud-Computing ?

Glaubst du das die Cloud ihren Datenfluss zum Anwender blind, ohne Personenbezogen Daten findet, und das der Anwender seine Daten in die Cloud ohne Bezug zu sich selbst hoch laden kann ?

Ehrlich, ich werde dieses sehr komplexe (zugleich verstörende) Thema jetzt auf cruislevel nicht weiter ausrollen; weil ich dafür weder die Zeit, noch die Geduld habe, und es mir innerlich bereits schmerzt mit soviel verzerrter, naiver Unwissenheit deinerseits konfrontiert zu werden.

Du wirst sicher „irgendwas zurück antworten“ um dein Weltbild weiter zu vebreiten, oder jemand anderes in deinem Namen.

Dazu kann ich nur sagen: Don’t feed the trolls, und ich melde mich zu diesem Thema, einschließlich Leitartikel, hiermit ab; kannst schreiben was du willst.

Over and out.

Sind wir schon hier auf heise-Forum Niveau?

Ich habe sachlich argumentiert und du wirst gleich Beleidigend weil jemand nicht 100% deiner Meinung ist?

Martin schrieb weiter oben:

und:

Ich denke ihre beide, @Jens und @stby04 seid dafür die besten Beispiele.

Der eine (stby04) schreibt oben von „abspritzen“, also sehr stumpf und niveaulos, und geht in seinem Rechtfertigunskommentar absolut gar nicht auf die grundsätzliche Argumentation von Martin ein: Nämlich das Microsoft Daten klaut und damit Geschäfte macht.

Ganz egal ob MS dies nun über seine Cloud-Geschäfte macht, oder über die unzähligen Telemetrie-Implentaionen im Betriebssystem. Wer ein wenig aufgeschlossen ist WEISS DAS , vor allem wenn man sich für IT Kanäle außerhalb des deutschen Sprachraumes interessiert , oder beim Namen Edward Snowden nicht gleich einen Verschwörungstheoretiker-Allergieschock mit Schnappatmung bekommt !!!

Einfach mal die hervorragende Freeware W10Privacy nutzen und man wird als User erschrocken fest stellen müssen wieviele Telemetrie (Auslese-) Funktionen und Hintertürchen MS in seinem OS eingepflanzt hat. (Anm.: das Linux immer mehr Fahrt aufnimmt, selbst im Gamingbereich, darf an dieser Stelle nicht wundern.).

Und der andere (Jens) kann es nicht aushalten wenn jemand eine andere Meinung wie er vertritt und fühlt sich in seinem Ego leicht gekränkt, in dem er andere der Beleidigung beschuldigt, obwohl Martin ihn gar nicht beleidigt hat.

Jens hat übrigens überhaupt nichts zum Hauptthema beigetragen, sondern macht bisher nur Polemik; anscheinend hat er den von Martin zitierten Artikel nicht einmal gelesen. Denn ob Heise ihn nun heraus gebracht hat oder nicht spielt überhaupt keine Rolle, den heise zitiert hier nur, der Inhalt selbst ist gar nicht von Heise.

Ich selbst sehe den zukünftigen Vorstoß MS’s auch im Gaming-/Flugsimulation immer in die Cloud zu gehen ebenfalls als sehr skeptisch an, denn dadurch werden wir User von äußeren Diensten immer mehr abhängig gemacht, ebenfalls vom Internet.

Mit der X-Box kann Microsoft natürlich super argumentieren warum eine noch größere Cloud in Zukunft so wichtig sei,

Aber ich selbst habe keine XBox, werde auch in Zukunft niemals eine haben, warum also nicht zwei Varianten des MSFS auf den Markt bringen ?

Eine abgespeckte für die Konsolen-Jünger, eine für die PC-Bauer wie ich selbst einer bin. Denn Datenspeicher wird immer günstiger; eine 2TB SSD im System nur für den MSFS (2024) unter zu bringen sollte kein allzu großes Problem darstellen, so bleibt man auch für kommende Jahre zukunftssicher.

Denn nach den aktuellen World-Update Problemen zu urteilen sehe ich eine sehr große, dunkle schwarze Wolke herauf dämmern die bereits jetzt den zukünftigen MSFS2024 verdunkelt.

Kann mir beim besten Willen nicht vorstellen wie das Team um Jörg Neumann und Asobo das im Laufe des kommenden Jahres geregelt bekommen wollen, sodaß die zukünftige Version des MSFS nicht mehr von jenen „Kinderkranheiten“ geplagt wird, wie es seit Release 2020 bereits der Fall ist.

Auch wenn ich es mir selbst wünschen würde. Weil der MSFS nun mal mein Nr.1 Game auf meinem geschätzten Rechner ist und sicher noch bleiben wird.

Wie Microsoft sein Geld verdient, unterliegt Fakten und nicht Meinungen. Das Cloud-Geschäft hat nichts mit dem Verkauf von Kundendaten zu tun. Microsoft Azure und Amazon Web Services (AWS) sind nichts anderes als verkaufte Rechenkapazität und darum aufgebaute Services, die es den Kunden ermöglichen weitgehend ohne eigene Hardware auszukommen und hochgradig skalierbar zu sein.

Die Datenerfassung von Windows 10 und höher auch noch andere Gründe: mit dem Release von Windows 10 hat Microsoft einen Großteil des Testing-Teams (über 3.000 Leute) entlassen. Die Telemetrie dient u.a. dazu Fehler im Betrieb zu schneller zu erkennen. Dass Microsoft dabei deutlich übers Ziel hinausschießt, ist nicht neu.

Letztendlich verdient aber Microsoft sein Geld zu einem sehr großen Teil mit seinen Produkten: Azure Cloud Services, Office 365-Abos, Windows-Lizenzen für Geschäftskunden, Xbox Game Pass und evtl. irgendwann auch mal mit den Konsolen selbst (aktuell eher unwahrscheinlich, da die Konsolen-Hersteller bei der Hardware oft draufzahlen und über die Spiele verdienen, zumindest bis sich die Konsolen billiger produzieren lassen, aber das sieht durch die aktuelle Weltwirtschaftsentwicklung eher mau aus).

Man vergleiche mit Google: dort ist der Kunde das Produkt und die Services darauf ausgelegt, möglichst viele Daten zu erfassen. Allerdings verdient Google sein Geld auch eh weniger mit dem Verkauf der Daten selbst und viel mehr damit, sie für Werbezwecke auszuwerten, um eine möglichst genaue Selektion von Zielgruppen zu ermöglichen. Da sie sehr früh damit angefangen haben und zusätzlich die Konkurrenz, z.B. DoubleClick, aufgekauft haben, sind sie durch ihre Reichweite ein Quasi-Monopolist.

Microsoft, Amazon, Apple & Co, die gerne regelmäßig als Datenkraken verschrien werden, aber ihr Geld eigentlich mit Dienstleistungen oder Hardware verdienen, haben nicht ansatzweise die nötigen Werbenetzwerke, um mit Google mithalten zu können. Wollen sie auch gar nicht. Der Werbemarkt ist sehr volatil. Und als Data Broker agieren sie auch nicht.

Das sind die Fakten zu dem Thema. Man kann dazu eine Meinung haben, aber bitte ohne unbewiesene Theorien, die teils haarsträubend von der Realität entfernt sind und eher nur zeigen, dass man gar nicht weiß, was die Cloud ist.

Was Snowdon angeht: er hat für die NSA gearbeitet, nicht Microsoft. Sicher verpflichten die USA ihre Firmen dazu, dass Geheimdienste Zugriff haben. Macht die Sache einfacher, aber letztendlich gilt auch: wenn die NSA irgendwo rein will, kommt sie das so oder so. Die mögen zwar auch ihre Fuckups haben, aber insgesamt, ist das bei weitem keine solche Gurkentruppe, wie der Verfassungsschutz beim Thema SIGINT.

Danke @webcodr

vorallem für das aufdröseln was „cloud“ eigentlich bedeutet 😉 Ich hatte

keine Motivation mehr dazu…

…hier wird gar nichts erklärt, schon gar nicht was eine Cloud ist. Fakt ist das es für eine Cloud Hardware- und Serverstrukturen braucht. Denn die Clouds des Himmels nehmen unsere Daten noch immer nicht auf.

Aber wer weiß, vielleicht haben Jens und webcodr mittlerweile ihre eigene Cloud auf dem Dach ihres Wohnhauses neben den Solarpanelen installiert 😄 ?

Ein anderer hier schrieb was von Scheuklappen, dem kann ich nur voll und ganz zustimmen. Deutschland ist in der Tat voll von solchen Leuten. Menschen die nicht gewillt sind über den Tellerrand hinaus zu blicken und weiterhin in ihrer (Medien-) Scheinwelt leben wollen.

Erstaunlich !

Doch, die Erklärung von @webcodr zur Cloud ist korrekt. Dass man dazu Server braucht bestreitet er ja gar nicht.

@webcodr schrieb:

Mein Gott, noch einer der mit Scheuklappen durch die IT-Welt tingelt; deutsche Medienpropagande und (Nicht-) Berichterstattungskultur hat in diesem Land wirklich ganze Arbeit geleistet. Chapeau !

Ich wußte das mein obiger Kommentar entsprechende Reaktionen hervorrufen wird. Was mich auf Grund der Reaktion der einzelnen Leute überrascht ist, das ich so trefflich richtig lag.

Ich kann euch nur raten einmal – versuchsweise – ein halbes Jahr gänzlich Abstand zu deutschen Medien und deutschsprachigen IT Kanälen zu halten (bis auf einen, der macht seine Sache sehr gut; denn werde ich hier aber nicht nennen). Und eure Infos für diese Zeit nur über US bzw. englischsprachige Techchannel Kanäle zu ziehen (die Kanadier sind dbzgl. auch sehr offen, kritisch und transparent).

Was ihr aber nicht tun werdet, weil ihr weiterhin in eurer bequemen (Schein-) Welt leben wollt; eventuelle Sprachbarrieren tun ihr übriges.

Microsoft macht einen grassierenden Insiderhandel mit unseren Daten, das ist FAKT; nach meinem Wissensstand den ich mir über Jahre aufgebaut habe gibt es dafür keinen Grund darüber zu zweifeln oder an Verschwörungen zu glauben. Die meisten Produkte die sie uns an die Nase drücken sind letztendlich nur Fassade um an unsere Daten zu kommen.

Was viele in ihren Köpfen nicht raffen ist, das es bei Daten nicht (nur) um Großmutters Brief geht oder unsere Steuererklärung die wir abgespeichert haben, oder unser Geburtsdatum.

Sondern auch speziell um Verhaltens- und psychologisch orientierte Daten. Wie zB. Konsumverhalten, oder auch Vektordaten, mittels derer über jede Person weltweit ein eigenes, psychologisches Profil erstellt wird. Man kennt diesen Begriff auch unter Profiling aus der Kriminalpsychologie; mittlerweile wird das aber im ganz großen Stil und über wetlweite Bevölkerungsgruppen gemacht; wo alle diese Profile auch jederzeit abgerufen werden können.

Microsoft, NSA, das ist ganz weit oben mittlerweile Eins geworden, und wir (die meisten zumindest) haben es nicht einmal gemerkt, und leben noch immer in dieser Scheinwelt eines „harmlosen“ Softwareunternehmens das einfach seine Produkte verkaufen will; was von Seiten der Macher natürlich gewollt ist.

Ich könnte jetzt mindestens zehn Youtuber bzw. Techchannel Betreiber aus dem stegreif hier aufzählen, die tlw. millionen Follower haben, und wo diese sensiblen Themen tlw. auch behandelt werden. Wenn zB. Windows/MS mal wieder neue Hürden im Registrierungsvorgang ihres OS (besonders Win11) eingebaut hat, um die Leute zu zwingen ein Online-Konto endlich anzulegen.

Werde ich aber nicht machen. Erstens ist cruiselevel dafür nicht die geeignete Plattform, und zweitens ist es sinnlos weil gewisse „Institutionen“ in euren Köpfen bereits ganze Arbeit geleitstet haben.

Ihr seid genau jene Kunden und Abnehmer die MS und ähnliche Konzerne sich auf lange Sicht wünschen; viel Feude im ihren Highlightss und Produkten 😁 .

Mehr dazu gibt es für mich nicht mehr zu sagen.

Okay, ich muss wohl etwas deutlicher werden: anstatt Quellen für Deine Behauptungen zu liefern, soll man selbst suchen und natürlich nicht die üblichen Medien konsumieren. Du hast alles selbst herausgefunden und kennst natürlich aus dem Stand zehn große YouTuber, die Deine Behauptungen unterstützen.

Du nennst weder konkret, welche ausländischen Medien besser berichten als unsere, noch nennst Du einen dieser YouTuber. Die deutsche Website, die ihre Sache Deiner Meinung nach gut macht, willst Du auch nicht rausrücken.

Mein Freund, Du bist hier in der Beweispflicht. Microsoft ist eine öffentlich gehandelte Aktiengesellschaft und unterliegt daher entsprechenden Rechenschaftspflichten wie Quartals- und Jahresberichten. Das gilt in den USA genauso wie hier. Dort wird sehr klar aufgeschlüsselt, womit Microsoft Geld verdient.

Und natürlich haben die meisten noch nichts davon gemerkt, dass Microsoft und die NSA eins wären. Warum sagst Du nicht gleich Schlafschafe? Damit wissen wir wenigstens alle woran wir sind …

Ich kann Dir nur raten, keine einfachen Antworten für komplexe Probleme zu suchen. Es gibt sie nämlich nicht und die Suche danach führt unweigerlich zu Vorstellungen wie Deinen.

Vergiss es, webcodr, Anhänger von VT werfen immer nur „den Anderen“ mangelndes kritisches Denken vor, selber machen sie dazu kaum bis gar keine Anstalten. Während also wir uns vorwerfen müssen, von tw. bis zu sämtlichen (!) bösen westlichen (DE) Medien oder Quellen an der Nase rumgeführt zu werden (da diese ja alle gleichgeschaltet sind *facepalm*), kann ein VT’ler ohne mit der Wimper zu zucken sein ganzes „Wissen“ aus ein und derselben Quelle beziehen. Das nennt er dann kritisches Denken, weil er ja eben nicht den Mainstream-Medien/Quellen auf den Leim geht. Alles klar? Macht gar keinen Sinn, da weiter zu Diskutieren oder noch mehr Fakten aufzutischen…

Ihr habt natürlich recht, aber man sollte solche Dinge auch nicht einfach unkommentiert stehen lassen. Nicht jeder ist in der Lage, auf Anhieb solche Verschwörungserzählungen zu erkennen – gerade auch wenn es um fachlichere Themen wie hier geht.

Also, jetzt mal Tacheles gesprochen, mein „Freund“:

Wenn, dann müßtest du zuerst beweisen das ich falsch liege !!!

Aber nun gut. Ich war hier bisher der erste und einzige der Quellen geliefert hat….(siehe Heise Artikel oben)….und davon gibt es mittlerweile im Internet wirklich, wirklich viele.

Selbst Onlinartikel aus renommierten Zeitungen, aber alles halt nicht in Deutsch, sondern (meist) in Englisch und aus dem Ausland.

Aber ihr wollt in eurem verqueren Weltbild bleiben. Selbst wenn ich hier Artikel oder Quellen nennen würde, würdet ihr euch gleich wie die Erbsenzähler darüber her machen und alles raus picken was ihr gegen mich, gegen diesen Artikel, für eure Argumentation hernehmen könnt, selbst wenn ihr dafür ein Mikroskop nehmen müßtet um etwas zu finden. So sehr seid ihr in eurer eigenen Dunstwolke des Irrglaubens bereits eingewoben.

Aber nun gut, ich werde gute Miene zum Bösen spiel zeigen und euch aus Gutwillen ein wenig „Arbeit“ abnehmen. Euch aber mit Löffel füttern und für euch auch noch kauen, sprich auch noch übersetzten, werde ich aber sicherlich NICHT.

Was ich unten zitiere sind nur Beispiele, weil es darüber bereits soviele Quellen gibt, wenn man sich ein bißchen Mühe macht.

1) ein interessanter Artikel aus dem „TheGuraridan“ aus dem Jahre 2013. Man kann davon ausgehen das es mittlerweile noch um ein Vielfaches schlimmer geworden ist:

Snowden document reveals key role of companies in NSA data collection (Link: https://www.theguardian.com/world/2013/nov/01/nsa-data-collection-tech-firms ) .

2) ein weitere, sehr interessanter Artikel aus dem Jahre 2021 der aufzeigt wie sehr die NSA im „Big Tech Business“ bereits involviert ist. Hier sogar – man glaube es kaum – mit Amazon, worüber sich lustigerweise MS beschwert 😅:

Microsoft says NSA needs to undo its $10B cloud computing contract with Amazon (Link: https://arstechnica.com/tech-policy/2021/08/microsoft-protests-amazons-10-billion-nsa-cloud-computing-contract/ ) .

Ist natürlich ein sehr kleine Auswahl, aber letztendlich ist cruislevel dafür nicht die geeignete Plattform. Ich denke, ihr Betbrüder werdet auch daran was zu „motzen“ haben.

Beste Grüße 😉.

Unglaubich 😯 , da wird einem fast schlecht wenn man diese Artikel liest.

Vor allem der zweite Artikel/Link wo sich Microsoft bei der NSA defakto beschwert, daß die NSA mit MS einen besseren Deal bezüglich CloudComputing gemacht hätte als mit Amazon, und deshalb die Ausschreibung/das Angebot noch einmal evaluieren sollte.

Sprich: Bitte liebe NSA, überdenkt euer Geschäft mit Amazon noch einmal. Wir von Microsoft können euch einen wesentlich besseren Deal bieten bzgl. Cloud Computing.

Dann noch weiter unten im Artikel die Stelle:

Echt, da haut’s mir fast die Birnen raus.

Amazon. sprich Amazon Web Services (AWS) stellt für die NSA bereits seit fast zehn Jahren die Plattformen für ihr CloudComputing (Überwachung/Datenspeicerung, etc…) zur Verfügung.

Und Microsoft versucht seit langem Amazon diesen Deal mit der NSA abzuluchsen indem es sogar anerkannte Einrichtungen bauen ließ (was sicher Milliarden von US Dollar gekostet hat) die die entsprechenden Server für Hochsicherheitsdaten bereit stellen.

Also, wenn man das richtig liest, dann biedert sich Microsoft der NSA ja richtig gehend an. Ja, da geht es wohl um Milliarden-Dollar Deals, hoch gerechnet über Jahrzehnte.

Da glaube ich auf jeden Fall Martin wenn er schreibt, das für MS das übliche Software-Geschäft mit uns Normalsterblichen schon längst zum Nebengeschäft geworden ist.

Zu diesen Machenschaften kann ich nur sagen: 🤢 🤮

Danke manuel ! Der Link im zweiten Artikel (du hast ihn zufällig rein kopiert), führt auch direkt zu einer vielsagenden Hauptseite von Microsoft, mit dem Titel:

Azure Government Secret new functionality

( https://azure.microsoft.com/en-us/blog/the-broadest-range-of-cloud-innovation-across-us-government-data-classifications/ )

D.h. es gibt von Azure auch ein hoch geheime Regierungsversion, und eine normale Regierungsversion. Zitat aus dem Artikel:

Azure Commercial ist natürlich das selbe was im MSFS verwendet wird. Dieses MS Dienstleisungsangebot (Anbiederung an die Regierung) ist von 2020, also kann man davon ausgehen das drei Jahre später die Dinge noch mehr verfilzt und verwoben sind. Zumal diese spezielle Version von Azur noch immer auf der MS Hauptseite angeboten wird. Es zeigt auch auf das der Code von Azure immer der selbe ist (wie wir es aus dem MSFS kennen) er aber in höhere Sicherheitsklassen „umgeformt“ werden kann.

Es zeigt halt wieder mal auf wie sehr MS in weltweiten Geheimdienstgeschäften und Dienstleisungen involviert ist. Nicht weil sie dazu gezwungen werden, sondern weil sich dahinter Milliarden-Dollar Deals befinden, wo der schlichte consumer-market wie wir ihn noch in Erinnerung haben schlichtweg verblasst.

Und sie verstecken es nicht einmal. Der Link führt direkt auf die MS Hauptseite, aber die meisten unter uns interessiert es (leider) nicht.

Das hier sind keine Verschwörungstheorien sondern knallharte Fakten.

…..nach diesem Link bin ich, ganz ehrlich gesprochen, eigentlich sprachlos, und mir ist noch mehr 🤢 🤢 🤢 🤮 🤮 🤮 .

Und hier ein weiterer, sehr interessanter Artikel aus dem Jahre 2019 der aufzeigt das mittlerweile sogar Daten-Verschlüsselungstechnologie (=encryption) die direkt von der NSA entwickelt wurde, Eingang im kommerziellen Bereich findet:

From the NSA to Silicon Valley, a new kind of encryption is going commercial (Link: https://cyberscoop.com/homomorphic-encryption-nsa-silicon-valley-commercial/ )

Ein Schelm wer dabei böses denkt 😉 .

Laß es sein Martin, als gut gemeinter Rat.

Mit Leuten wie zB. Christian, webcodr, Jens kann man über diese heiklen Dinge nicht diskutieren. Die können nicht (mehr) über den Tellerrand hinaus blicken.

Die sind so sehr in ihrem verfestigten und bequemen Weltbild gefangen, dazu tut die hiesige Medienlandschaft ihr übriges, bei denen ist Hopfen und Malz verloren.

Schon lustig das ausgerechnet von dir Beweispflicht eingefordert wird, obwohl du bisher der einzige warst der hier Fakten über Links angegeben hat; und dann natürlich die leidige und ewig gleiche Argumentation ein Verschörungstheoretiker zu sein, von der Gegenseite – Hauptsache emotional bleiben und ohne Substanz.

Auch ich mache diese Erfahrung in Deutschland immer wieder. Selbst wenn man Fakten zur Hand hat wird man auf Grund einer anderen Sichtweise oftmals als verrückter Aluhutträger und Verschwörungstheoretiker abgestempelt, meist ohne gelieferte Fakten durch die Gegenseite.

Deshalb halte ich mich mittelerweile bedeckt und diskutiere hierzulande interessante Themen abseits der GEZ und RTL Medienlandschaft nur noch mit Vetrauten und Freunden, was ich auch dir rate; sonst reibt man sich nur unnötig auf.

So ihr Mäuse. In unserer Bude geht’s um Flugsimulation! Und vielleicht mal Download-Probs beim MSFS. Irgendwelche Diskussionen ums Datensammeln mit verbalen Hieben hören jetzt auf, sonst mach ich die Kommentarspalte dicht. Nutzt dafür andere Plattformen. Dankö. Gruß und Kuss, euer Julius.

Klar, verstehen wir, ist auch gut so das du das schreibst, lieber Julius.

Aber der Artikel-Link zu den verschiedenen Versionen von Microsoft’s Azur war schon Bombe 😁.

Denn Azur betrifft auch den MSFS, und wer hätte gedacht das Microsoft davon auch eine hoch geheime „Azure Goverment Top Secret“ Version offiziell über ihre hauseigene Seite anbietet.

Wer weiß, vielleicht findet diese Top Secret Variante auch bald Einzug im kommenden MSFS 2024, loooooooool, ich lach mich scheckig……

Wenn man diesen fast unglaublichen Artikel bzg.MS’s Azure ansieht (s.o), vor allem die darin angezeigte Grafik, dann besteht der gesamte Überbau Microsoft Azure aus vier Hauptkomponenten:

Daraus kann man schlußfolgern das durch Azure täglich unglaubliche, gewaltige, fast bodenlose Datensätze durchströmen..

Und wer weiß, vielleicht wird Azure selbst deshalb immer wieder zu einen Flaschenhals, was dann am Ende der Leitung bei uns Simmern als die üblichen Update-Apokalypsen in Erscheinung tritt.

So wären wir im Kontext auch wieder bei Andreas’s Hauptartikel angelangt

Und dann gäbe es natürlich auch noch den leidigen Punkt der Priorisierung.

D.h. Dantensätze mit Top Secret Klassifzierung würden schneller durch Azures Leitung „rutschen“, hätten höhere Priorität als zB. die ollen Daten für uns Flusianer 😄 , und wir würden wieder am Tropf hängen.

Könnte was dran sein….

Erstmal Danke für die Erläuterungen. Komplexe Netzwerk-Themen verständlich zu erklären, ist wirklich nicht einfach. Ich möchte zu den CDNs noch ergänzen, dass es sich dabei um weit mehr als nur ein paar Server handelt. Alleine für Azure Deutschland dürften mehrere Tausend CDN-Server an unterschiedlichen Standorten und mit Anbindungen an unterschiedliche Carrier, große Netzwerkknoten wie DE-CIX in Frankfurt oder z.T. auch an die Internet-Anbieter (ISPs) bereitstehen.

Die im letzten Absatz erwähnten Probleme durch die ISPs bzw. deren Verbindungen in anderen Netze (Peerings) sind leider oft ein größeres Problem. Ein Beispiel: ISP X hat kein direktes Peering zu Azure, sondern muss über einen Knotenpunkt wie DE-CIX gehen. Nun hat X ein Peering zu DE-CIX mit 200 Gbit/s. Darüber läuft alles, was von Kunden von X zu Azures CDN-Region für DE-CIX, also z.B. Teams, Office 365, Bing Maps, Xbox, Azure Cloud-Kunden und natürlich der MSFS. 200 Gbit/s klingen viel, aber können bei vielen Kunden auch sehr schnell eng werden und dann greifen ISPs ein, um die Verbindung nicht zu überlasten. Sog. Traffic Shaping sorgt dafür, dass das Peering nicht komplett zusammenbricht und gar nichts mehr geht. Jeder bekommt nun geringere Bandbreite, teilweise werden auch ganze Netzwerk-Pakete einfach weggeschmissen. Solches sog. Packet Loss sorgt z.B. bei empfindlichen Anwendungen wie VoIP, Streaming oder auch Spielen für Probleme. Bei Downloads ist es nicht so dramatisch, wird einfach nur langsamer, außer der Packet Loss wird extrem.

Ein weiterer Flaschenhals kann auch die Zugangstechnik sein. Vor allem Kabel kann sehr anfällig sein, hängt stark vom Ausbau der Infrastruktur ab. Bei DSL oder Glasfaser, man hat eine diskrete Verbindung bis zum nächsten Verteilerkasten, von dort laufen dann richtig dicke Glasfaserleitungen in die weitere Infrastruktur des ISPs. Bei Kabel dagegen ist der Anteil der gemeinsam genutzten Infrastruktur viel näher am Kunden. Das Netz wird in Segmente aufgeteilt und jeder in einem Segment teilt sich die Bandbreite mit anderen Kunden. Je nach dem wie groß der ISP die Segmente gewählt hat und welche Produkte angeboten werden, kann es schnell eng werden und man rennt in eine sog. Segmentüberlastung. Abhilfe kann leider dauern, weil u.U. neue Leitungen für eine weitere Segmentierung gelegt werden müssen. Es gibt in modernen Ausbau-Gebieten mit viel Glasfaser, die dann auch sehr nahe am Kunden liegt, auch software-definierte Segmente, die sich schnell anpassen lassen, aber der Ausbaustand ist bei weitem nicht so weit, dass sowas flächendeckend verfügbar ist.

Es gibt also einige Fehlerquellen (sind mehr, aber das sprengt den Rahmen) bei Download-Problemen, miesen Pings oder Streaming-Aussetzern, die nicht in der Kontrolle des Inhaltsanbieters liegen. Ich hatte z.B. immer wieder extreme Probleme mit Vodafone Kabel – nicht nur was den MSFS betrifft. Meist war es eine Kombination aus einem überlasteten Segment und Peering-Problemen. Online-Spiele waren teils unmöglich. Nach einem Wechsel zur Telekom, ging dann alles weitgehend problemlos. Aber auch die Telekom kann mal Peering-Probleme haben. Kein ISP ist frei davon.

Wow jetzt habe ich zum ersten Mal in meinem Leben gecheckt, was bei „Paketverlust“ genau passiert 😀

Geil, noch mal sehr gut erklärt, verständlich gemacht, und gut zusammen gefasst. Vielen Dank für deinen tollen Beitrag 👍 🤩 .

Schön, dass MS versucht da irgendwas zu erklären. Problem ist nur, dass die miserablen Download Geschwindigkeiten zu weiten Teilen immer noch bestehen. Sie können da so viel rum tweaken wie sie wollen. Wenn die Server Kapazität nicht reicht, dann reicht sie halt nicht. Und langsam nervt das auch. Wenn man ein Cloud basiertes Produkt anbietet, soll man auch sicherstellen, dass das vernünftig läuft.

Bist Du nicht der, der in der ersten News zu den Downloadproblemen iwas von lahmen WLAN oder Inet und langsame SSD geschwafelt hat? Jetzt ist es plötzlich Fakt, dass die Server-Kapazität nicht reicht? Ein echtes Genie ist hier unterwegs, Hut ab.

Wüsste ich ehrlich gesagt nicht, aber ich weiß auch nicht genau was dieser Kommentar aussagen soll, weil sich beides übrigens nicht ausschließen würde. Und ja, die Datenlast ist selbstverständlich inzwischen höher, die Serverkapazitäten sind offenbar nicht mitgewachsen und die Downloadgeschwindigkeiten sind schwankend schon seit mehreren World- und Sim-Updates teils miserabel und vor allem regional unterschiedlich. Und ob du mich für einen Experten hältst oder nicht ist mir eigentlich so ziemlich egal.

…du beschreibst genau das was ich auch auf meinem System praktisch seit Release des MSFS beobachte bzgl. der Downloadgeschwindigkeiten. Ich vermute das der Fix oben auch wieder nur ein Flicken-Stückwerk bis zur nächsten Download – „Apokalypse“ sein wird.

Dennoch hoffe ich insgeheim das ich Unrecht habe, denn mir liegt der MSFS sehr am Herzen. Aber dieses chronische Zittern vor anstehenden World Updates geht mir langsam echt auf den Sack, meine Nerven sind nicht mehr die besten 🙃.

Die nächsten Monster-Updates werden es zeigen, und spätestens der MSFS2024 wird die Feuertaufe für MS/Asobo sein und sollten sie noch mehr in die Cloud umlagern wollen.

Danke für deinen Kommentar !

Ich finde das klasse, das im Nachhinein auch mal Fehler erläutert werden. Technisch absolut interessant wie sowas zu Stande kommt. das sind schon Datenmengen 🙂

Ja, es rafft nur die Mehrheit nicht. Die denken das ist wie Brötchen verkaufen, aber soweit zu denken was passiert wenn eine komplette Großstadt gleichzeitig bei einem einzigen Bäcker aufläuft reicht es nicht mehr.

Hab heute erst das SU gemacht, problemlos 60Mbit. Allerdings hat alles andere an Marktplatz Updates im Profilmanager nur mit 1,5Mbit geladen

Jetzt frage ich mich als absoluter Laie nur, warum es bei Microsoft Probleme gibt, aber zB bei Steam, wo etwa bei großen Spiele Releases wahrscheinlich hundert mal so viel Traffic zur selben Zeit bei deren Servern aufkommt, immer alles rund läuft. Ganz zu schweigen von Youtube oder Twitch, wenn mehrere Millionen zeitgleiche Videoaufrufe und Livestreams zu bewältigen sind. Da ist die kleine Flightsim Community doch ein Witz gegen mit ihren 7GB die sie alle paar Monate von diesen Servern haben wollen. Haben Steam und co auch so ein riesiges Netz aus Content Delivery Network Servern, oder haben die eine ganz andere Herangehensweise? Und wenn ja, warum macht es Microsoft anders? Dieses ganze SAS Token senden und hin und her, nur damit „gewiefte Simmer“ sich nicht bei PlayFab einschleichen wirkt irgendwie unnötig kompliziert (wer tut das schon, es gibt ja keine Kreditkarten zu klauen bei Sim Updates), wenn man bedenkt, dass das eigentliche Ziel, ein schnellerer Download für alle dadurch ins Gegenteil umschlägt. Wenn das so weitergeht schleiche ich mich bald wirklich bei Playfab ein und hole mir die Daten von dort 😀

Klasse Beitrag, vielen Dank. Ich hatte zwar den MS Beitrag gelesen, aber die zusätzlichen Erklärungen helfen beim Verständnis.

Zum letzten Absatz: Du schreibst in einer Anmerkung im Beitrag, dass es unterschiedliche Auslieferungsmethoden gibt.

Mir ist im letzten Developer Q&A aufgefallen, dass Martial Brussard sich beim Thema langsame Downloads im Content Manager widersprochen hat: zunächst sprach er von regionalen Unterschieden und dass das in Bordeaux nicht vorkäme (in dem Zusammenhang fiel wohl auch die Bemerkung, die möglicherweise auf Azure/Providerursachen hindeutete), um danach Besserung durch Änderungen am Client in Aussicht zu stellen. Obwohl es ja keine regionalen Unterschiede geben dürfte, wenn die Ursache beim Client liegt. Nebelkerze?

Ist durchaus beides möglich. Man sieht ja z.B. gut das der Download meist sehr langsam anfängt und irgendwann schnell wird, bis das Spielchen beim nächsten Paket wieder von vorne losgeht. Wenn man nun zum Beispiel weniger große Pakete baut statt vieler kleiner sollte die durchschnittliche Geschwindigkeit trotzdem steigen.